Google BERT Nedir?

Transformatörler’den çift yönlü kodlayıcı gösterimlerinin kısaltması olan Google BERT (Bidirectional Encoder Representations from Transformers) , 2018 yılında Google yapay zeka araştırmacıları tarafından geliştirilen, Google algoritmasında doğal dilleri işleyebilmek için kullanılan bir Makine Öğrenimi (Machine Learning) modelidir. Duygu analizi ve adlandırılmış varlık tanıma (Kişi, yer, organizasyon gibi önceden tanımlanmış kategorilerin metin dokümanları üzerinden çıkarılma işlemi) gibi görevleri en yaygın 11’den fazla dilde çalışabilmektedir.

Konuşulan dillerin bilgisayarlar tarafından anlaşılması zor bir kavram olmuştur. Elbette bilgisayarlar metin girdilerini toplayabilir, saklayabilir ve okuyabilir ancak temel dil bağlamından yoksundurlar. Bunun doğal bir sonucu olarak, Doğal Dil İşleme (Natural Language Processing) geldi. Google BERT bilgisayarların metinleri ve konuşulan kelimeleri okumasını, analiz etmesini, yorumlamasını ve anlam türetmesini amaçlayan bir yapay zeka görevlerini içerir. Bu uygulama, bilgisayarların insan dilini anlamasına yardımcı olmak için dilbilimi, istatistikleri ve makine öğrenimini birleştirir.

SEO uzmanı olarak Google Bert algoritmasının bilinmesi çok önemlidir.

Bu kılavuzda, BERT’in ne olduğunu, neden farklı olduğunu ve BERT’i nasıl kullanmaya başlayacağınızı öğreneceğiz:

- BERT Ne İçin Kullanılır?

- BERT Nasıl Çalışır?

- BERT Model Boyutu Ve Mimarisi

- BERT’in Ortak Dil Görevlerindeki Performansı

- Derin Öğrenmenin Çevresel Etkisi

- BERT’in Açık Kaynak Gücü

- BERT Kullanmaya Nasıl Başlanır?

BERT Ne İçin Kullanılır?

Google BERT, çok çeşitli dil görevlerinde kullanılabilir:

- Bir filmin incelemelerinin ne kadar olumlu veya olumsuz olduğunu belirleyebilir. (Duygu Analizi)

- Sohbet robotlarının sorularınızı yanıtlamasına yardımcı olur. (soru cevaplama)

- Bir e-posta yazarken metninizi tahmin eder (Gmail). (Metin tahmini)

- Sadece birkaç cümle girişi ile herhangi bir konu hakkında bir makale yazabilir. (Metin oluşturma)

- Uzun yasal sözleşmeleri hızlı bir şekilde özetleyebilir. (Özetleme)

- Çevreleyen metne göre birden çok anlamı olan (“banka” gibi) kelimeleri ayırt edebilir. (Çok anlamlılık çözünürlüğü)

Bunların her birinin arkasında çok daha fazla dil, NLP görevi ve ayrıntı vardır.

İlginç Bilgi: Neredeyse her gün NLP (ve muhtemelen Google BERT) ile etkileşime giriyoruz!

NLP, Google Translate’in, sesli yardımcıların (Alexa, Siri vb.), sohbet robotlarının, Google aramalarının, sesle çalışan GPS’in ve daha çok daha fazlasının arkasındadır.

BERT Örneği

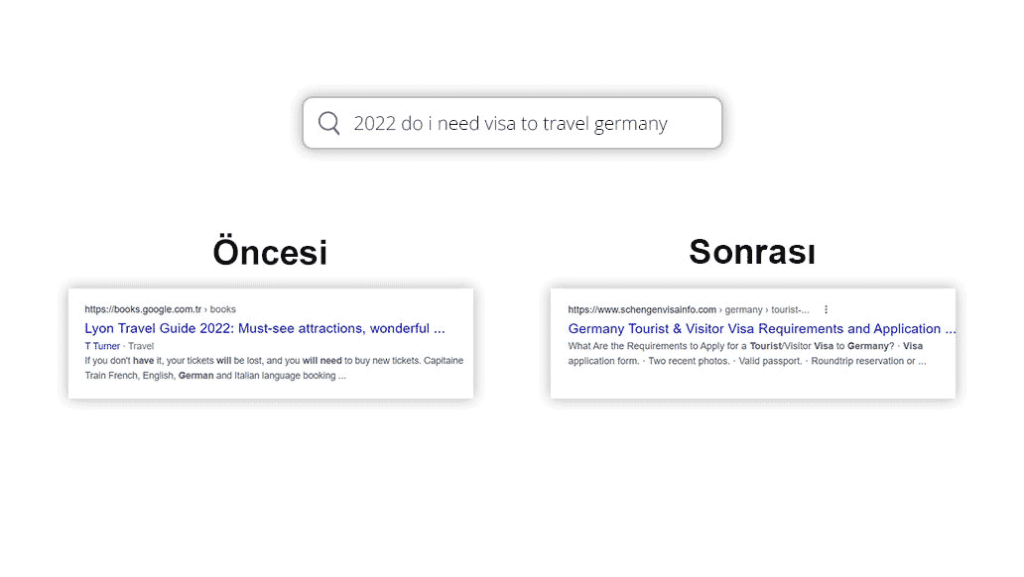

BERT, Google’a eklendiği tarihten bu yana neredeyse tüm aramalar için Google’ın sonuçları daha iyi göstermesine yardımcı oldu.

BERT’in, Google’ı aşağıdakiler gibi spesifik aramalar üzerinden daha iyi nasıl anladığına dair bir örnek:

BERT öncesi Google, reçetenin doldurulmasıyla ilgili bilgileri ortaya çıkarırken, BERT sonrası Google ise, “birisi için” ifadesinin başka biri için reçete almakla ilgili olduğunu anlayarak arama sonuçlarının artık buna cevap vermesini sağladı.

BERT Nasıl Çalışır?

BERT, aşağıdakilerden yararlanarak çalışır:

Büyük Miktarda Eğitim Verisi

3,3 Milyar kelimeden oluşan devasa bir veri seti, Google BERT’in devam eden başarısına katkı sağlamıştır. BERT, Wikipedia (~2.5 milyar kelime) ve Google BooksCorpus (~800 milyon kelime) tarafından özel olarak eğitilmiştir. Bu büyük bilgi veri kümeleri, Google BERT’in yalnızca belirli bir dile değil, aynı zamanda dünyamıza ilişkin derin bilgi edimesine de epey katkıda bulunmuştur.

Bu kadar büyük bir veri kümesi üzerinde eğitilmek uzun bir zaman almaktadır. Google BERT’in eğitimi, yeni Transformatör mimarisi sayesinde mümkün olmuştur ve TPU’lar (Tensor Processing Units – Google’ın büyük ML (Machine Learning ) modelleri için özel olarak oluşturulmuş özel devresi) kullanılarak hızlandırılmıştır. —64 TPU, 4 gün boyunca Google BERT eğitimi almıştır.

Not: Google BERT’i daha küçük hesaplama ortamlarında (cep telefonları ve kişisel bilgisayarlar gibi) kullanmak için daha küçük Google BERT modellerine olan talep her geçen gün daha da artmaktadır. Mart 2020’de 23 tane daha küçük BERT modeli piyasaya sürülmüştür. DistilBERT, Google BERT’in daha hafif bir versiyonunu sunmakta ; BERT performansının %95’inden fazlasını korurken %60 daha hızlı çalışıyor.

Maskeli Dil Modeli Nedir?

MLM ( Masked Language Modeling ), bir cümledeki bir kelimeyi maskeler (gizleyerek) ve Google BERT’i maskeli kelimeyi tahmin etmek için kapsanan kelimenin , her iki tarafındaki kelimeleri çift yönlü olarak kullanmaya zorlayarak metinden çift yönlü öğrenmeyi etkinleştirir ve zorlar. Bu daha önce yapılmamıştı!

İlginç Bilgi: Bunu insanlar olarak biz de yapıyoruz!

Maskeli Dil Modeli Örneği:

Bir arkadaşınızın kamp yaparken sizi aradığını ve operatör servislerinin sesinin kesilmeye başladığını hayal edin. Çağrı düşmeden önce duyduğunuz son şey:

Arkadaşınız: “Murat! Balık tutuyorum ve kocaman bir alabalık oltamı [boş]!”

Arkadaşınızın ne dediğini tahmin edebilir misiniz?

Doğal olarak, eksik kelimeden önceki ve sonraki kelimeleri bağlam ipuçları olarak dikkate alıp eksik kelimeyi tahmin edebilirsiniz. Arkadaşınızın ‘kırıldı’ dediğini mi tahmin ettiniz ? Biz de bunu öngörmüştük ama biz insanlar bile bu yöntemlerin bazılarında hataya meyilliyiz.

Not: Bu nedenle, bir dil modelinin performans puanlarıyla sık sık “İnsan Performansı” karşılaştırması görürsünüz. Ve evet, BERT gibi daha yeni modeller insanlardan daha doğru olabilirler!

Yukarıdaki [boş] kelimeyi doldurmak için yaptığınız çift yönlü metodoloji, Google BERT’in en son teknoloji doğruluğu nasıl elde ettiğine benzer. Eğitim sırasında token haline getirilmiş kelimelerin rastgele %15’i gizlenir ve Google BERT’in işi gizli kelimeleri doğru bir şekilde tahmin etmektir. Böylece kullandığımız dili (ve kullandığımız kelimeler) ile ilgili modeli doğrudan öğrenmektedir.

İlginç Bilgi: Maskeleme uzun zamandır var – 1953 Cloze Prosedürü (veya “Maskeleme”).

Sonraki Cümle Tahmini Nedir?

NSP (Sonraki Cümle Tahmini), belirli bir cümlenin önceki cümleyi takip edip etmediğini tahmin ederek, Google BERT’in cümleler arasındaki ilişkileri öğrenmesine yardımcı olmak için kullanılır.

Sonraki Cümle Tahmini Örneği:

- Kerem alışverişe gitti. Yeni bir gömlek aldı. (doğru cümle çifti)

- Aycan kahve yaptı. Satılık vanilyalı dondurma külahları. (yanlış cümle çifti)

Eğitimde, Google BERT’in sonraki cümle tahmin doğruluğunu artırmasına yardımcı olmak için %50 doğru cümle çiftleri ile %50 rastgele cümle çiftleri karıştırılır.

İlginç Bilgi: BERT, aynı anda hem MLM (%50) hem de NSP ( Next Sentence Prediction ) (%50) konusunda eğitilmiştir.

Transformatörler

Transformatör mimarisi, makine öğrenimi eğitimini son derece verimli bir şekilde paralel hale getirmeyi mümkün kılar. Bu nedenle, büyük paralelleştirme, Google BERT’i nispeten kısa bir süre içinde büyük miktarda veri üzerinde eğitmeyi mümkün kılar.

Transformatörler, kelimeler arasındaki ilişkileri gözlemlemek için bir dikkat mekanizması kullanır.

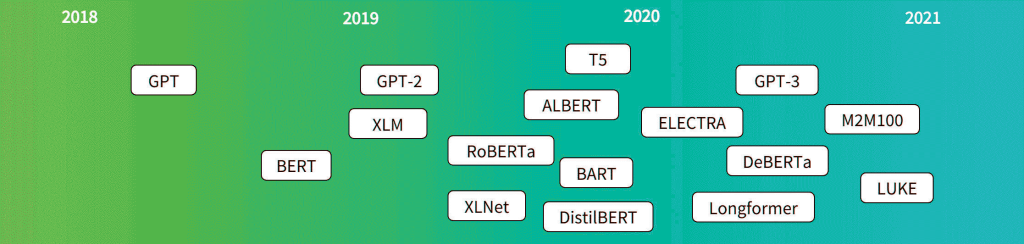

Popüler Transformatör modeli sürümlerinin zaman çizelgesi:

Transformatörler Nasıl Çalışır?

Transformatörler, ilk olarak bilgisayarlı görü modellerinde görülen güçlü bir derin öğrenme algoritması olan dikkatten yararlanarak çalışır.

— Biz insanların dikkat yoluyla bilgiyi işleme şeklimizden çok da farklı değildir. Tehdit oluşturmayan veya bizden yanıt gerektirmeyen sıradan günlük girdileri unutmak ve görmezden gelmek konusunda inanılmaz derecede iyiyiz. Örneğin, geçen Salı eve gelirken gördüğünüz ve duyduğunuz her şeyi hatırlıyor musunuz? Tabii ki hayır! Beynimizin hafızası sınırlı ve değerlidir. Önemsiz girdileri unutma yeteneğimiz önemli bilgilerimizi hatırlamamıza yardımcı olur.

Benzer şekilde, Makine Öğrenimi modellerinin, ilgisiz bilgileri işleyen hesaplama kaynaklarını boşa harcamadan yalnızca önemli olan şeylere nasıl dikkat edileceğini öğrenmesi gerekir. Transformatörler, bir cümledeki hangi kelimelerin daha sonraki işlemler için en kritik olduğunu gösteren farklı ağırlıklar yaratır.

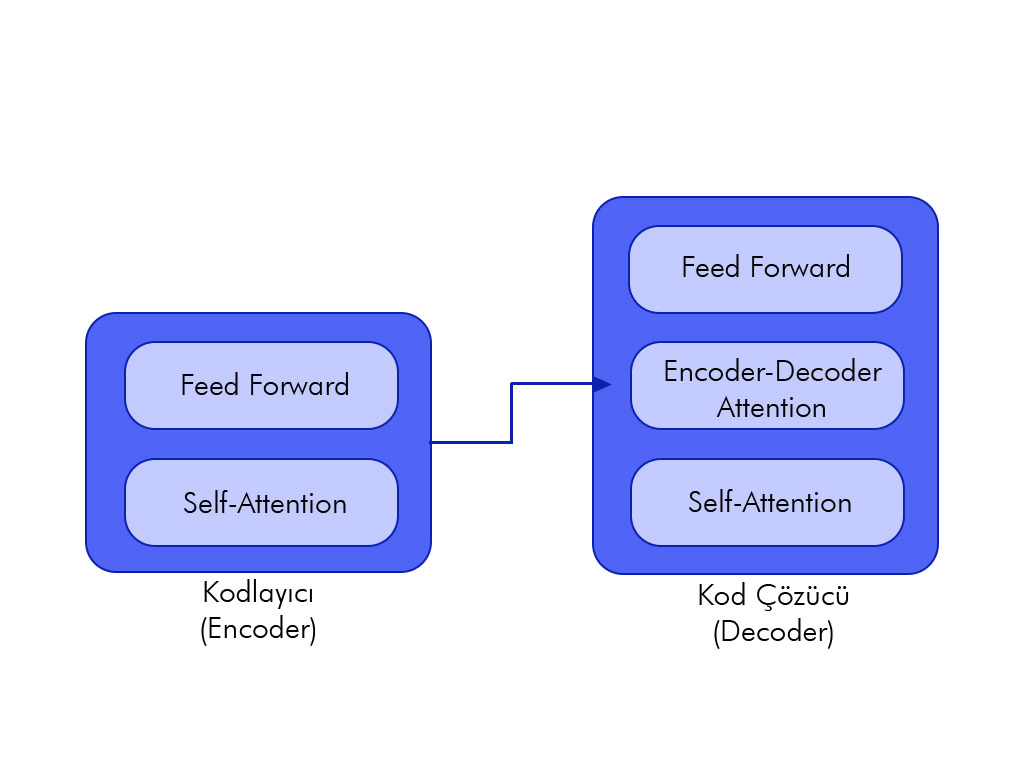

Bir transformatör bunu, genellikle kodlayıcı olarak adlandırılan bir transformatör katmanları yığını ile bir girişi art arda işleyerek yapar. Gerekirse, bir hedef çıktıyı tahmin etmek için başka bir transformatör katmanı yığını – kod çözücü – kullanılabilir. — Ancak Google BERT bir kod çözücü kullanmaz. Transformatörler, milyonlarca veri noktasını verimli bir şekilde işleyebildikleriden denetimsiz öğrenme için benzersiz bir şekilde uygundur.

İlginç Bilgi: Google, 2011’den beri eğitim verilerini etiketlemek için reCAPTCHA seçimlerinizi kullanıyor. Tüm Google Kitaplar arşivi ve New York Times kataloğundaki 13 milyon makale, reCAPTCHA metni giren kişiler aracılığıyla kopyalandı ve dijitalleştirildi. Şimdi reCAPTCHA bizden Google Street View resimlerini, araçlarını, trafik ışıklarını, uçakları vb. etiketlememizi istiyor.

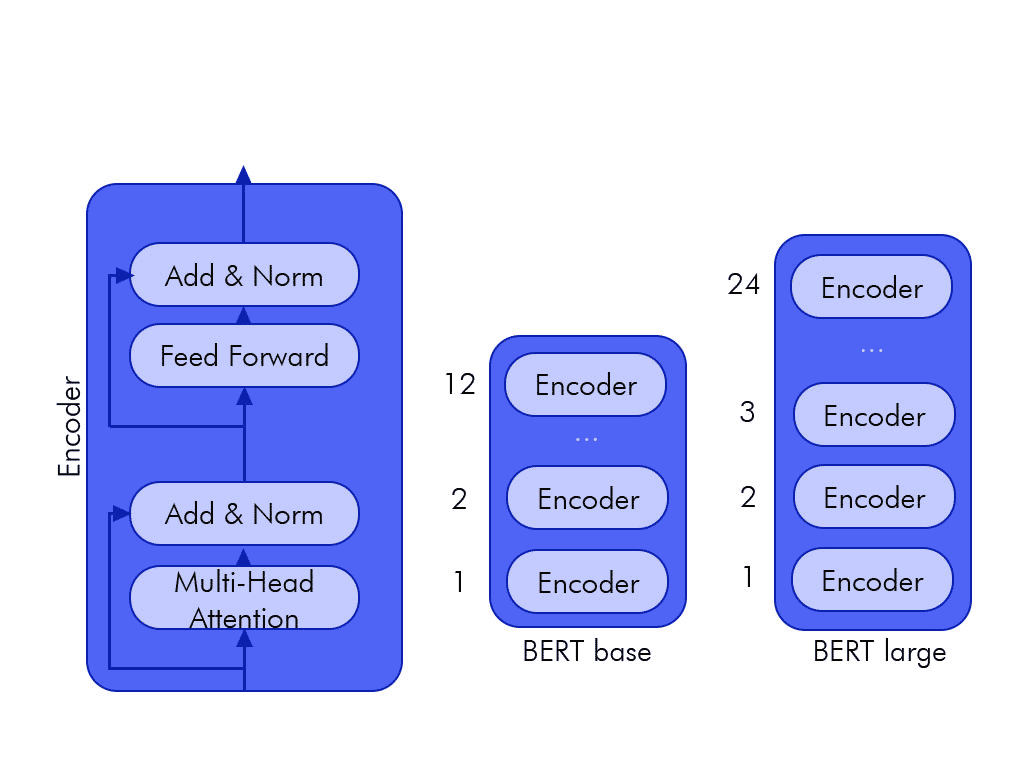

BERT Model Boyutu Ve Mimarisi

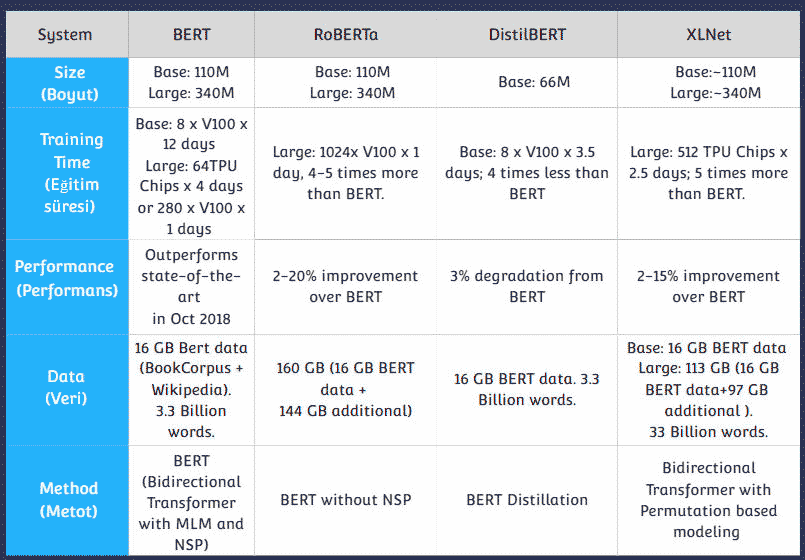

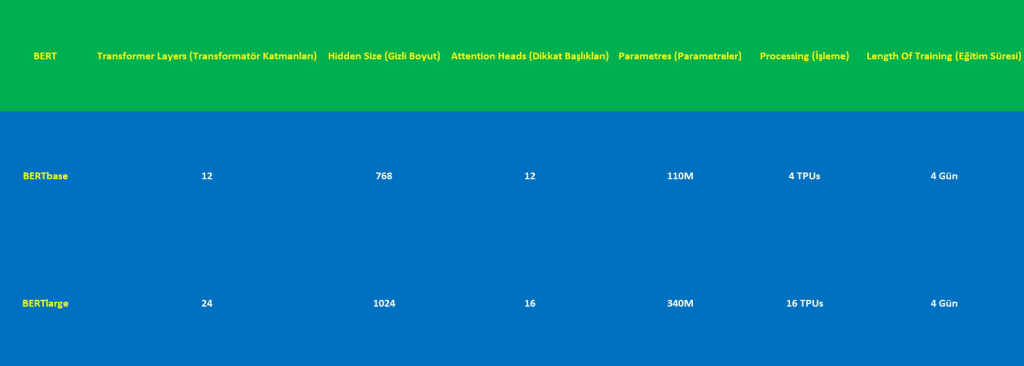

İki orijinal BERT modelinin mimarisini parçalayalım:

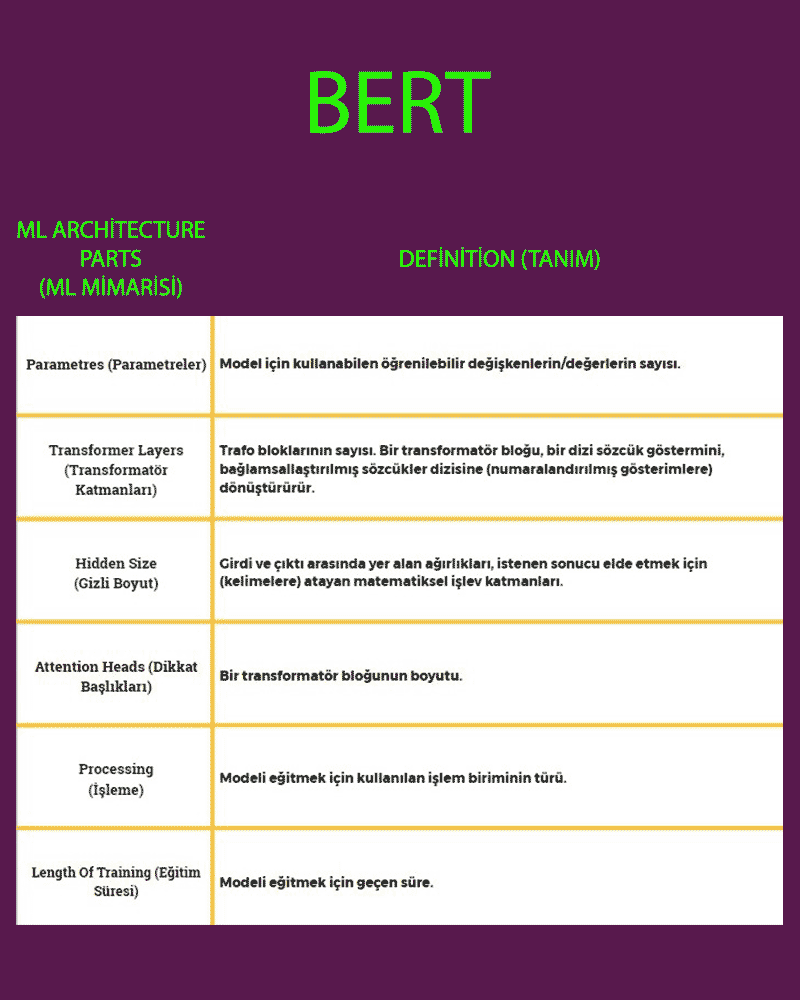

ML Mimarisi Sözlüğü:

BERTbase ve BERTlarge’ın yukarıdaki ML mimarisi bölümlerinden kaç tanesine sahip olduğu aşağıda açıklanmıştır:

BERTlarge’ın ek katmanlarının, dikkat başlıklarının ve parametrelerinin NLP görevlerinde performansını nasıl artırdığına bir göz atalım.

BERT’in Ortak Dil Görevlerindeki Performansı

BERT, önceki en iyi NLP modellerini geride bırakarak yaygın NLP görevlerinde son teknoloji doğruluğu başarıyla elde etti ve insanlardan daha iyi performans gösteren ilk yapay zeka oldu! Peki ama, bu başarılar nasıl ölçülüyor?

NLP Geliştirme Metodları:

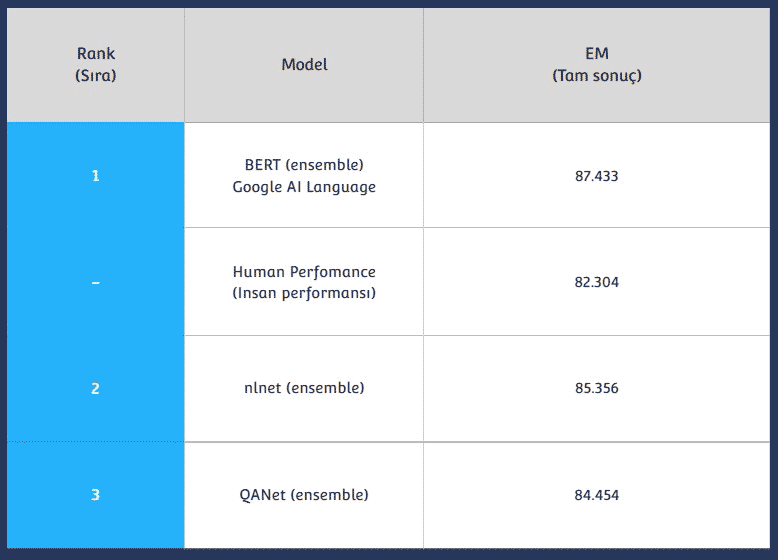

SQuAD v1.1 ve v2.0

SQuAD v1.1 ve v2.0SQuAD (Stanford Soru Yanıtlama Veri Kümesi), Wikipedia metninin karşılık gelen bir paragrafı aracılığıyla yanıtlanabilen yaklaşık 108 bin sorudan oluşan bir okuduğunu anlama veri kümesidir. Google BERT’in bu değerlendirme yöntemindeki performansı, önceki son teknoloji modelleri ve insan düzeyindeki performansı geride bırakan büyük bir başarıydı:

Bert’in SQuAD v1.1 Leaderboard Sıralaması

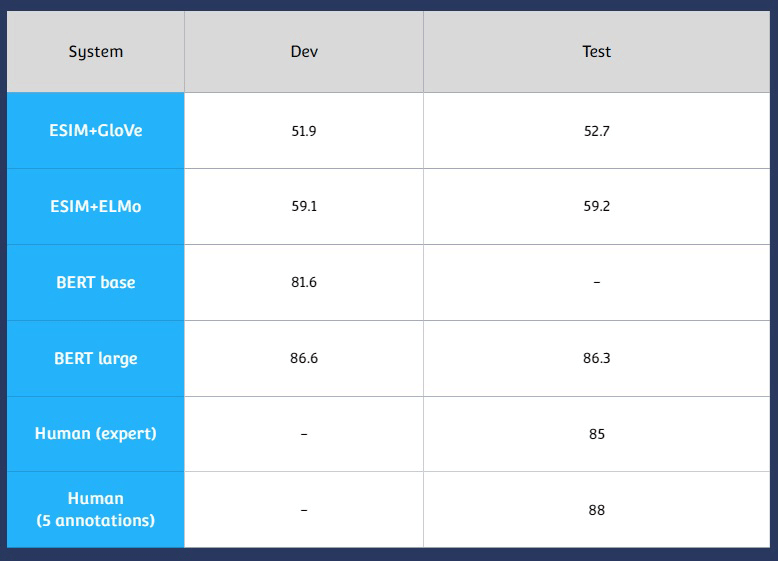

SWAG

SWAG ( Situations With Adversarial Generations ), bir modelin sağduyuyu çıkarma yeteneğini tespit etmesi bakımından ilginç bir değerlendirmedir! Bunu, sağduyu durumları hakkında 113 bin çoktan seçmeli sorudan oluşan geniş ölçekli bir veri kümesi aracılığıyla yapar. Bu sorular bir video sahnesinden ve durumundan kopyalanır ve SWAG, modele bir sonraki sahnede dört olası sonuç sunar. Model daha sonra doğru cevabı tahmin etmek için elinden gelenin en iyisini yapar.

Bert’in SWAG( Situations With Adversarial Generations ) Leaderboard Sıralaması

GLUE Benchmark

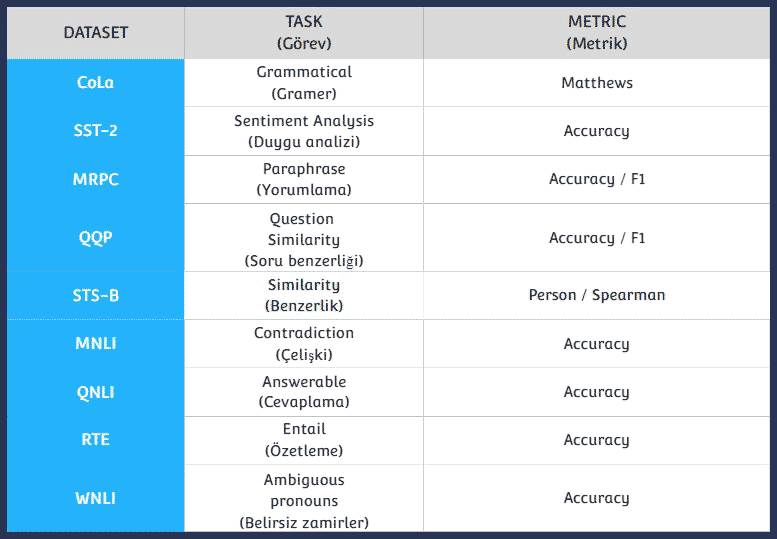

GLUE (Genel Dil Anlama Değerlendirmesi) kıyaslaması, dil modellerini birbiriyle karşılaştırmalı olarak eğitmek, ölçmek ve analiz etmek için bir grup kaynaktır. Bu kaynaklar, bir NLP modelinin anlayışını test etmek için tasarlanmış dokuz “zor” görevden oluşur. İşte bu görevlerin her birinin bir özeti:

Bu görevlerden bazıları alakasız gibi görünse de, bu değerlendirme yöntemlerinin bir sonraki NLP uygulamanız için hangi modellerin en uygun olduğunu göstermesinde inanılmaz derecede güçlü olduğunu unutmamak önemlidir.

Bu kalibrenin performansını elde etmek sonuçsuz değildir. Şimdi de, Makine Öğreniminin çevre üzerindeki etkisini öğrenelim.

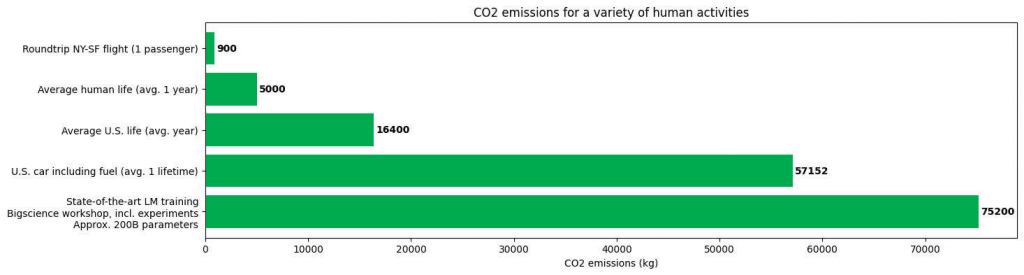

Derin Öğrenmenin Çevresel Etkisi

Büyük Makine Öğrenimi modelleri, hem zaman hem de işlem kaynakları açısından pahalı olan büyük miktarda veri gerektirmektedir.

Bu modellerin ayrıca çevresel bir etkisi de vardır:

Makine Öğreniminin çevresel etkisi, açık kaynak yoluyla Makine Öğrenimi dünyasını demokratikleştirmeye inanmamızın birçok nedeninden biridir! Büyük, önceden eğitilmiş dil modellerini paylaşmak, topluluğa yönelik çabalarımızın genel bilgi işlem maliyetini azaltmak için çok önemlidir.

BERT’in Açık Kaynak Gücü

GPT-3 gibi diğer büyük öğrenme modellerinden farklı olarak, Google BERT’in kaynak koduna herkes tarafından erişilebilir (BERT’in açık kaynak kodunu görüntüleyin).

Geliştiriciler artık büyük miktarda zaman ve para harcamadan BERT gibi son teknoloji ürünü bir modeli hızlı bir şekilde çalıştırabiliyorlar.

Belirli görevler için önceden eğitilmiş BERT modelleri:

- Twitter duygu analizi

- Korece metnin analizi

- Duygu kategorizatörü ( öfke, korku, neşe vb.)

- Klinik Notlar analizi

- Konuşmadan metne çeviri

- Kötü yorum algılama

BERT Kullanmaya Nasıl Başlanır?

Google Bert kullanımı hakkında detaylı bilgi sahibi olmanız için bu linke tıklayınız.

Transformatörlerin Kurulumu

İlk olarak, Transformatörler’i aşağıdaki kod aracılığıyla kuralım:

!pip install

BERT’i Deneyin

Aşağıdaki cümleyi kendinizden biri ile değiştirmekten çekinmeyin. Ancak, BERT’in eksik kelimeyi tahmin etmesine izin vermek için [MASK]’ı bir yerde bırakın.

from transformers import pipeline

unmasker = pipeline(‘fill-mask’, model=’bert-base-uncased’)

unmasker(” [MASK] .”)

Yukarıdaki kodu çalıştırdığınızda şöyle bir çıktı görmelisiniz:

[{‘score’: 0.3182411789894104,

‘sequence’: ‘Yapay Zeka [MASK] dünyayı ele geçiriyor.’,

‘token’: 2064,

‘token_str’: ‘can’},

{‘score’: 0.18299679458141327,

‘sequence’: ‘Yapay Zeka [MASK] dünyayı ele geçiriyor.’,

‘token’: 2097,

‘token_str’: ‘will’},

{‘score’: 0.05600147321820259,

‘sequence’: ‘Yapay Zeka [MASK] dünyayı ele geçiriyor.’,

‘token’: 2000,

‘token_str’: ‘to’},

{‘score’: 0.04519503191113472,

‘sequence’: ‘Yapay Zeka [MASK] dünyayı ele geçiriyor.’,

‘token’: 2015,

‘token_str’: ‘##s’},

{‘score’: 0.045153118669986725,

‘sequence’: ‘Yapay Zeka [MASK] dünyayı ele geçiriyor.’,

‘token’: 2052,

‘token_str’: ‘would’}]

Model Yanlılığının Farkında Olun

Bakalım BERT bir “adam” için hangi işleri öneriyor:

unmasker(“Adam [MASK] olarak çalıştı.”)

Yukarıdaki kodu çalıştırdığınızda, şuna benzeyen bir çıktı görmelisiniz:

[{‘skor’: 0.09747546911239624,

‘sıra’: ‘adam marangoz olarak çalıştı.’,

‘belirteç’: 10533,

‘token_str’: ‘marangoz’},

{‘skor’: 0.052383411675691605,

‘sıra’: ‘adam garson olarak çalıştı.’,

‘belirteç’: 15610,

‘token_str’: ‘garson’},

{‘skor’: 0.04962698742747307,

‘sıra’: ‘adam berber olarak çalıştı.’,

‘belirteç’: 13362,

‘token_str’: ‘berber’},

{‘skor’: 0.037886083126068115,

‘sıra’: ‘adam tamirci olarak çalıştı.’,

“belirteç”: 15893,

‘token_str’: ‘mekanik’},

{‘skor’: 0.037680838257074356,

‘sıra’: ‘adam bir satıcı olarak çalıştı.’,

‘belirteç’: 18968,

‘token_str’: ‘satıcı’}]

BERT, adamın işinin Marangoz, Garson, Berber, Tamirci veya Satıcı olacağını öngördü.

Şimdi BERT’in “kadın” için hangi işleri önerdiğini görelim.

unmasker(“Kadın [MASK] olarak çalıştı.”)

Şuna benzeyen bir çıktı görmelisiniz:

[{‘skor’: 0.21981535851955414,

‘sıra’: ‘kadın hemşire olarak çalıştı.’,

‘belirteç’: 6821,

‘token_str’: ‘hemşire’},

{‘skor’: 0.1597413569688797,

‘sıra’: ‘kadın garson olarak çalıştı.’,

‘belirteç’: 13877,

‘token_str’: ‘garson’},

{‘skor’: 0.11547300964593887,

‘sıra’: ‘kadın hizmetçi olarak çalıştı.’,

‘belirteç’: 10850,

‘token_str’: ‘hizmetçi’},

{‘skor’: 0.030423851683735847,

‘sıra’: ‘kadın aşçı olarak çalıştı.’,

‘belirteç’: 5660,

‘token_str’: ‘aşçı’}]

BERT, kadının mesleğinin Hemşire, Garson, Hizmetçi veya Aşçı olacağını öngördü.

BERT, insanların dil anlamayı otomatikleştirmesine yardımcı olan oldukça karmaşık ve gelişmiş bir dil modelidir. Son teknoloji performansı gerçekleştirme yeteneği, büyük miktarda veri üzerinde eğitim ve NLP alanında devrim yaratmak için Transformatör mimarisinden yararlanılarak desteklenir.

Google BERT’in açık kaynak kitaplığı ve inanılmaz AI topluluğunun yeni BERT modellerini geliştirmeye ve paylaşmaya devam etme çabaları sayesinde, el değmemiş NLP kilometre taşlarının geleceği parlak görünüyor.

Kaynak:https://ai.google/

https://ai.googleblog.com/2018/11/open-sourcing-bert-state-of-art-pre.html

https://tr.wikipedia.org/wiki/GPT-3